Cómo Google, con Gemini, está utilizando TPU en lugar de GPU — y por qué esto supone un menor coste de cómputo y energético

En los últimos años, el desarrollo de modelos de inteligencia artificial ha requerido una enorme capacidad de procesamiento. Tradicionalmente, las GPU han sido el estándar para entrenar y ejecutar modelos avanzados, como los utilizados por plataformas como OpenAI. Sin embargo, Google ha apostado por un enfoque distinto al impulsar Gemini, su suite de modelos generativos, sobre una arquitectura propia: las TPU (Tensor Processing Units).

Las TPU están diseñadas específicamente para cálculos de inteligencia artificial, lo que permite a Google optimizar tanto el rendimiento como el coste energético. Esta diferencia tecnológica no solo marca un camino alternativo dentro del sector, sino que también redefine cómo las empresas pueden abordar el entrenamiento y despliegue de modelos de IA a gran escala.

Desde IMAGAR analizamos por qué esta decisión estratégica de Google es clave para la evolución del mercado y cuáles son sus implicaciones para la eficiencia, la escalabilidad y los costes operativos.

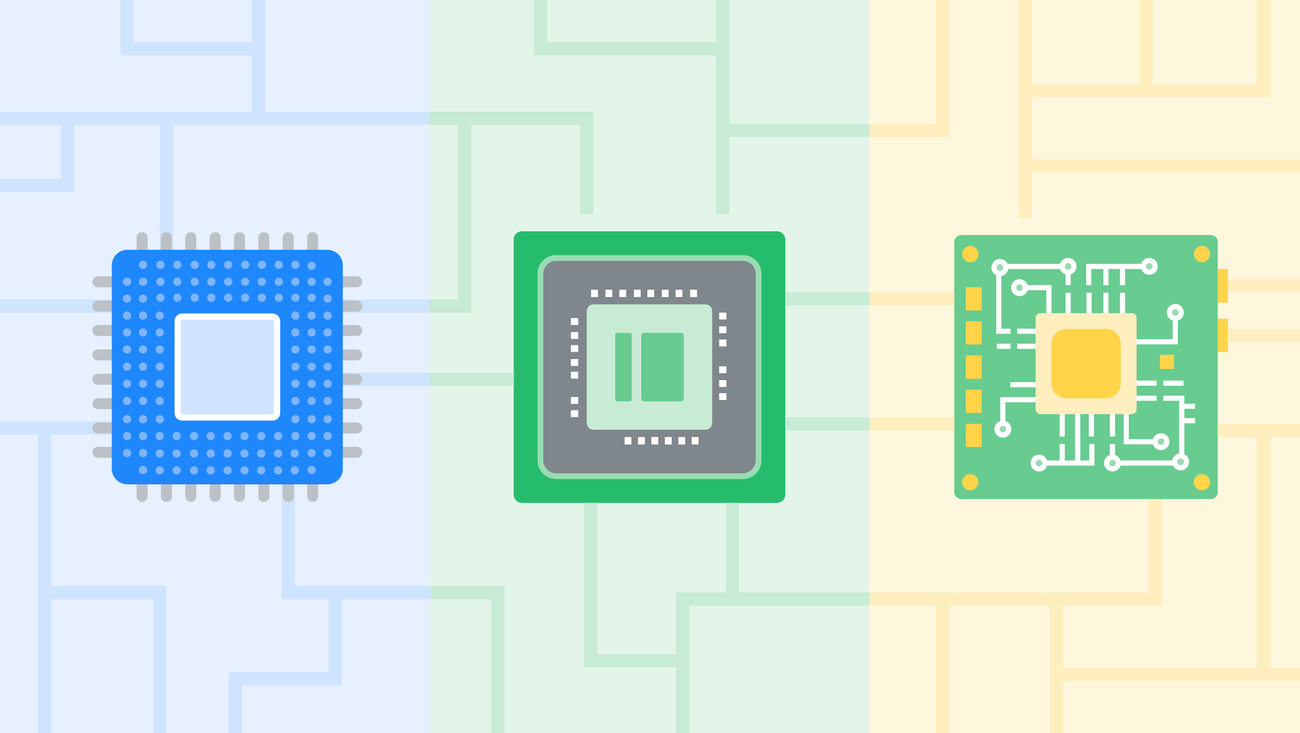

TPU en lugar de GPU

Una evolución natural para la IA de gran escala

Mientras que las GPU —utilizadas por OpenAI y otros proveedores— están optimizadas para cálculos gráficos y paralelos, las TPU de Google han sido desarrolladas expresamente para:

Cálculo intensivo de redes neuronales

Operaciones masivas de matrices

Entrenamiento de modelos multimodales

Inferencia rápida y eficiente

La diferencia es significativa:

las TPU son hardware especializado para IA, mientras que las GPU son hardware versátil optimizado parcialmente para IA.

Entre las ventajas más destacadas de las TPU encontramos:

Menor consumo energético por operación.

Mayor rendimiento en cargas de trabajo específicas de IA.

Reducción del coste de entrenamiento por token generado.

Mayor escalabilidad en centros de datos optimizados.

Integración nativa con la infraestructura de Google Cloud.

Cómo Google utiliza TPU para impulsar Gemini

Los modelos Gemini han sido diseñados desde su origen para aprovechar el potencial de las TPU. Esto les permite:

Entrenar modelos de gran tamaño con menor coste

La eficiencia de las TPU permite entrenar modelos multimodales (texto, imagen, audio, vídeo) reduciendo el coste computacional por unidad de procesamiento.Optimizar el rendimiento en entornos de producción

El uso de TPU para inferencia permite respuestas más rápidas y menor consumo energético.Escalar de forma masiva

Google puede crear clústeres de TPU altamente interconectados, optimizando la velocidad de entrenamiento y disponibilidad.Reducir el impacto ambiental

La eficiencia energética de las TPU contribuye a un modelo más sostenible de IA a gran escala.

Ventajas clave del uso de TPU frente a GPU

1. Coste de cómputo más bajo

El hardware especializado reduce el número de ciclos necesarios para realizar operaciones de IA, lo que se traduce en:

Menor coste por hora de entrenamiento

Menor coste por millón de tokens generados

Diseño más optimizado para cargas de IA empresarial

2. Menor consumo energético

Las TPU consumen menos energía para obtener el mismo rendimiento que una GPU en tareas de IA.

Esto implica:

Centros de datos más eficientes

Reducción de costes operativos

Menor impacto ecológico

3. Mayor velocidad en entrenamientos complejos

Las TPU incorporan unidades especializadas en multiplicaciones de matrices (clave en IA), permitiendo acelerar significativamente:

Entrenamientos multimodales

Modelos con miles de millones de parámetros

Procesos de fine-tuning

4. Infraestructura optimizada para IA generativa

Al controlar tanto software como hardware, Google puede:

Afinar el rendimiento de sus modelos Gemini

Optimizar el ciclo completo de IA: entrenamiento + inferencia

Escalar sin depender de hardware externo

Cómo afecta esta estrategia al mercado de IA

El uso intensivo de TPU por parte de Google, frente al modelo basado en GPU empleado por OpenAI, introduce cambios relevantes:

Competencia por eficiencia, no solo por potencia

Reducción de costes globales en servicios de IA

Mayor disponibilidad de modelos a menor precio

Fomento de infraestructuras más sostenibles

Democratización del acceso empresarial a modelos avanzados

Gemini se posiciona así como una alternativa altamente competitiva tanto en coste como en capacidad técnica.

La visión desde IMAGAR

Adoptar IA de manera eficiente y estratégica

En IMAGAR ayudamos a las organizaciones a integrar inteligencia artificial desde un enfoque práctico, seguro y orientado a resultados. Nuestro trabajo consiste en:

Identificar qué plataformas de IA encajan mejor con cada necesidad.

Evaluar costes de cómputo y despliegue a nivel empresarial.

Diseñar arquitecturas híbridas basadas en modelos cloud.

Integrar IA generativa en entornos Microsoft, Google Cloud o independientes.

Optimizar rendimiento, automatización y eficiencia.

Nuestro objetivo es que las empresas adopten IA de forma sostenible, rentable y alineada con su estrategia tecnológica.

IA, eficiencia y futuro

La elección de Google de impulsar Gemini sobre TPU demuestra que la IA no solo avanza en capacidades, sino también en optimización y sostenibilidad.

El futuro estará marcado por modelos:

Más rápidos

Más eficientes

Más económicos

Mejor integrados en los procesos empresariales

Y la clave estará en elegir las arquitecturas adecuadas.

¿Quieres integrar IA generativa en tu organización?

En IMAGAR te acompañamos en todo el proceso: desde la identificación de casos de uso hasta la implementación y el mantenimiento.

Solicita información o presupuesto sin compromiso. Estaremos encantados de ayudarte.